Volume 42 Number 4

Statistical testing in wound care

John Stephenson

Keywords inferential statistical tests, p value, confidence intervals, odds ratio

For referencing Stephenson J. Statistical testing in wound care. WCET® Journal 2022;42(4):38-40

DOI

https://doi.org/10.33235/wcet.42.4.38-40

Submitted 6 November 2022

Accepted 1 December 2022

Wound care studies generally yield quantitative data; and that data require some form of analysis. Almost all studies include a descriptive summary of participants, as discussed in my previous article1. However, many studies also require some form of inferential statistical testing; usually if the intention is to generalise findings from the sample to a population.

Different study designs require different testing methods, although the basic aim in most cases is the same. This is to assess the significance of the effect of interest; that is, to establish whether any effect we see in our sample data is a reflection of the state of affairs in the parent population, or likely to be nothing more than random variation in our data. An effect could be an observed difference between study groups (such as amount of biofilm present in a control group and a group where patients are treated with an anti-microbial dressing), the difference between a measure taken at baseline and post-intervention from a single patient group (such as pain levels during and after surgery), an observed relationship between two variables (such as the extent of mobile health technology use and wound care knowledge) or many other quantities.

Establishment of statistical significance requires a test of a hypothesis. We usually test a null hypothesis (of no effect); for example, that the difference in means in the population is zero. Miller et al2 conducted a pilot single-blinded randomised controlled trial (RCT) to examine concordance with and acceptability of electric stimulation therapy (EST) in patients with venous leg ulcers (VLUs) who had not tolerated moderate to high compression. The treatment was tested against the null hypothesis of no effect; i.e. that concordance with the total recommended treatment time under control treatment or under EST was the same. Lenselink and Andriessen3 measured (among other quantities) the percentage of granulation tissue and yellow tissue in a cohort study on the efficacy of a polyhexanide-containing biocellulose dressing in 28 patients, testing several hypotheses relating to differences in patient outcomes between baseline and 24 weeks. In a study of diabetic and non-diabetic patients, Gunes et al4 analysed several biomarkers, primarily galectin-3 (which promotes angiogenesis and new vessel formation) and tested several hypotheses relating to relationships between galectin-3 and various other biomarkers.

Significance is quantified using the familiar (if not widely understood) p-value, which is a conditional probability: the probability that observed results, or something more extreme, would have been obtained, given that the null hypothesis is true. In everyday parlance it is referred to loosely as ‘the chance of a chance’: that is, the probability that our data has fallen the way it has just as a result of natural variation and not because an effect actually exists. Conventionally, a p-value below 0.05 (5%) is taken as indicating an outcome of statistical significance (at the 5% significance level) and a consequential rejection of the null hypothesis of no effect. The study of Miller et al yielded a p-value of 0.671 for its primary outcome; indicating insufficient evidence for a difference between treatment groups. The study of Lenselink and Andriessen yielded a p-value reported to be less than 0.04 for a test comparing the mean percentage of granulation tissue from baseline to 24 weeks post-treatment; indicating evidence for a treatment effect. The study of Gunes et al yielded a p-value of less than 0.001 in a test for correlation between the galectin-3 and C-reactive protein biomarkers, indicating strong evidence for a significant relationship between these biomarkers.

The RCT conducted by Miller et al and the test of changes from baseline conducted by Lenselink and Andriessen are examples of grouped study designs: an unpaired study, in which two unrelated study groups are compared, in the case of Miller et al and a paired study design, in which the measures are taken on two occasions from the same group of patients, in the case of Lenselink and Andriessen (the word ‘paired’ refers to the fact that each patient contributes a pair of readings, not that a pair of groups is involved). Another variant of this study arises when measures are taken from patients matched on demographic or health-related variables. The study of Gunes et al is an example of a correlational design using ungrouped data. These three designs are probably the most common choices of study design in wound care, although various other study types, which also aim to infer results from sample data to a population may be found, including for example tests of agreement, screening/diagnostic studies, survival analysis and meta-analysis.

Numerical outcomes in unpaired studies can be compared using the independent samples t-test, or, if more than two groups are involved, a test such as analysis of variance (ANOVA). Categorical outcomes are usually analysed using the chi-squared test for association. For the paired study design, the standard analysis technique is the paired samples t-test or the repeated measures ANOVA. Correlational studies are usually quantified via Pearson’s correlation coefficient, and may be extended into a linear regression setting. All these procedures are parametric procedures which make certain distributional assumptions about the data; if these assumptions are not fulfilled, corresponding non-parametric techniques, such as the rank-sum test, signed ranks test, evaluation of Spearman’s rank correlation coefficient or bootstrapping procedures can often work quite well. All procedures may be easily implemented using standard statistical software and all will yield an assessment of statistical significance as measured by the p-value and given by the software.

While the p-value facilitates an inference of statistical significance or otherwise, it does not give us a measure of precision in our results. This is another side to inferential testing. We may find in our sample an effect of a given size, but it would not be realistic to expect that an effect of precisely that magnitude exists in the wider population. While we will never know what the size of the population effect actually is, it is possible to derive a confidence interval (CI), also known as an uncertainty interval, for it. This is often interpreted loosely as the range of values within which we can state to a certain degree of confidence (conventionally 95%) that a population value lies. More formally, if we were to repeat the procedure many times, then the range of values determined each time would contain the true population parameter on 95% of occasions.

CIs do not quantify the strength of evidence against the null hypothesis, as the p-value does, but instead give a measure of the precision of an estimate (for example, the difference between, or ratio of, the mean values in treatment groups). Nowadays CIs (and the estimate of effect around which they are fitted) are increasingly reported alongside p-values in statistical testing and appear to many to be more informative and easier to understand. While they do not form part of a hypothesis test, most statistical software will automatically report a CI as a by-product of the hypothesis test output.

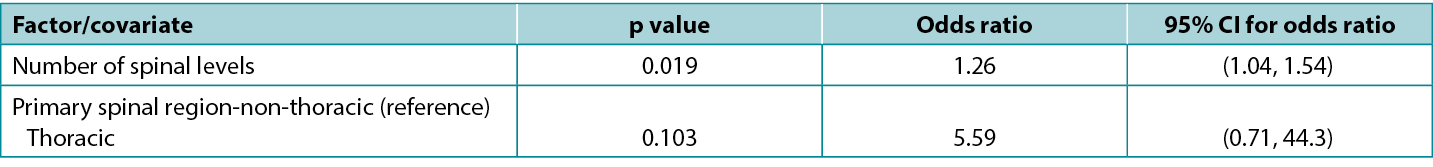

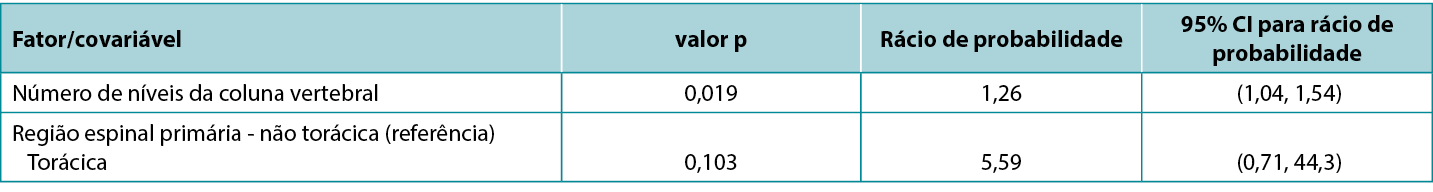

There is an exact correspondence between CIs and the corresponding p-value: a 95% CI that excludes the key value 0 (for a difference between study groups) or 1 (for a ratio between study groups) corresponds to a significant effect at the 5% significance level (i.e. a p-value that is less than 0.05). Conversely, a 95% CI that includes a key value corresponds to a p-value that is statistically non-significant at the 5% significance level (i.e. is 0.05 or greater). Atkinson et al5 investigated the effect of various factors on risk of surgical site infection during spinal surgery and in a typical presentation of tabulated results (below), reported statistics from a model including both p-values and CIs. Note that the spinal levels factor, which is significant according to the p-value (0.019), has an odds ratio with an associated CI of 1.04 to 1.54, which excludes the key value (for a ratio) of 1; while the spinal region factor, which is non-significant according to the p-value (0.103), has an odds ratio with an associated CI of 0.71 to 44.3, which includes the key value. This table is also a good example of how an effect of relatively small magnitude (each additional spinal level is associated with a 26% increase in odds of infection) may be significant; whereas an effect of large magnitude (surgery performed in the thoracic, rather than non-thoracic region is associated with about a fivefold increase in odds of infection) may be non-significant.

Table 1: extract from data table reported by Atkinson et al5

Selection of an appropriate statistical test for a given study design is not always straightforward and requires careful consideration of study parameters. No single test is suitable for all types of studies. For grouped studies, such as the unpaired and paired designs discussed above, we may need to consider, for example, the number of groups, the size of the groups, the distribution of data, the independence of units and the presence or absence of confounding factors in selecting a test. For ungrouped studies, such as correlational studies, we may wish to consider whether our data is in the form of raw data or rank orderings; and for ungrouped studies assessing multiple factors, we may wish to consider whether we are potentially overfitting our data (modelling noise rather than signal) by attempting to analyse too many factors for a sample of a given size.

Special measures are needed for complex designs: for example when data is clustered (such as patients within hospital wards, or anatomical sites within patients); when multiple tests are being conducted (such as may arise in studies with multiple outcome measures, where the key treatment variable has multiple levels, or where separate analyses are conducted on sub-groups of individuals and/or at multiple time points); when outcomes are not known exactly (such as when an outcome is the time to an adverse event in patients who are monitored infrequently); when a series of observations are made on the same patients; or when it is required to determine a synthesised estimate of effect from multiple studies. Certain data features, such as the presence of extensive missing or invalid values or outliers may also lead to a requirement for additional statistical processes. In all such situations it is recommended that the advice of a biomedical statistician is sought.

Testes estatísticos no tratamento de feridas

John Stephenson

DOI: https://doi.org/10.33235/wcet.42.4.38-40

Os estudos de tratamento de feridas geralmente produzem dados quantitativos; e esses dados requerem alguma forma de análise. Quase todos os estudos incluem um resumo descritivo dos participantes, tal como foi discutido no meu artigo anterior1. No entanto, muitos estudos também requerem alguma forma de testes estatísticos inferenciais; geralmente se o objetivo é o de generalizar os resultados da amostra a uma população.

Os diferentes desenhos de estudo requerem métodos de ensaio diferentes, embora o objetivo básico na maioria dos casos seja idêntico. Isto serve para avaliar a significância do efeito em avaliação; isto é, para estabelecer se qualquer efeito que vemos na nossa amostra de dados é um reflexo do estado das coisas na população-mãe, ou se é provável que este não seja mais do que uma variação aleatória nos nossos dados. Um efeito poderia ser uma diferença observada entre grupos de estudo (como a quantidade de biofilme presente num grupo de controlo e num grupo em que os pacientes são tratados com um penso antimicrobiano), a diferença entre uma medida tomada na linha de base e no pós-intervenção de um único grupo de pacientes (tais como os níveis de dor durante e após a cirurgia), uma relação observada entre duas variáveis (como o grau de utilização da tecnologia de saúde móvel e o conhecimento sobre cuidados com feridas) ou muitas outras quantidades.

O estabelecimento da significância estatística requer um teste de uma hipótese. Normalmente testamos uma hipótese nula (ou seja, sem efeito); por exemplo, que a diferença de meios na população é zero. Miller et al2 conduziram um ensaio piloto cego aleatório controlado (RCT) para examinar a concordância e a aceitabilidade da terapia de estimulação elétrica (EST) em pacientes com úlceras venosas de perna (VLU) e que não tinham tolerado compressão moderada a alta. O tratamento foi testado contra a hipótese nula de nenhum efeito; ou seja, que a concordância com o tempo total recomendado para o tratamento sob controlo ou sob EST era a mesma. Num estudo de coorte sobre a eficácia de um penso biocelulósico contendo poli-hexanida em 28 pacientes, Lenselink e Andriessen3 mediram (entre outras quantidades) a percentagem de tecido de granulação e de tecido amarelo, testando várias hipóteses relacionadas com diferenças nos resultados dos pacientes entre a linha de base e as 24 semanas. Gunes et al4, num estudo de pacientes diabéticos e não diabéticos, analisaram vários biomarcadores, principalmente a galectina-3 (a qual promove a angiogénese e a formação de novos vasos) e testaram várias hipóteses relacionadas com as relações entre a galectina-3 e vários outros biomarcadores.

A significância é quantificada utilizando o valor p familiar (se não for amplamente compreendido), o qual é uma probabilidade condicional: a probabilidade de que os resultados observados, ou algo mais extremo, terem sido obtidos, dado que a hipótese nula é verdadeira. Na linguagem quotidiana é referida vagamente como "a oportunidade de uma oportunidade": ou seja, a probabilidade de os nossos dados terem surgido como resultado de uma variação natural e não porque exista realmente um efeito. Convencionalmente, um valor p inferior a 0,05 (5%) é considerado como que indicando um resultado de significância estatística (ao nível de 5% de significância) e uma consequente rejeição da hipótese nula de nenhum efeito. O estudo de Miller et al produziu um valor p de 0,671 para o seu resultado primário; o que indica provas insuficientes para uma diferença entre os grupos de tratamento. O estudo de Lenselink e Andriessen produziu um valor p inferior a 0,04 para um teste que compara a percentagem média de tecido de granulação da linha de base com 24 semanas de pós-tratamento; indicando provas de um efeito de tratamento. O estudo de Gunes et al produziu um valor p inferior a 0,001 num teste de correlação entre os biomarcadores de proteína galectina-3 e C-reativa, indicando fortes evidências de uma relação significativa entre estes dois biomarcadores.

O RCT realizado por Miller et al e o teste de alterações a partir da linha de base conduzido por Lenselink e Andriessen são exemplos de desenhos de estudo agrupados: um estudo não emparelhado, no qual são comparados dois grupos de estudo não relacionados, no caso de Miller et al e um desenho de estudo emparelhado, no qual as medidas são tomadas em duas ocasiões a partir do mesmo grupo de pacientes, no caso de Lenselink e Andriessen (a palavra "emparelhado" refere-se ao facto de cada paciente contribui com um par de leituras, não que esteja envolvido um par de grupos). Uma outra variante deste estudo surge quando são tomadas medidas de pacientes que correspondem a variáveis demográficas ou a variáveis relacionadas com a saúde. O estudo de Gunes et al é um exemplo de um desenho correlacional utilizando dados não agrupados. Estes três desenhos são, provavelmente, as escolhas mais comuns de desenho de estudo no tratamento de feridas, embora possam ser encontrados vários outros tipos de estudo, que também visam inferir resultados a partir de dados de uma amostra para uma população, incluindo, por exemplo, testes de concordância, estudos de rastreio/diagnóstico, análise de sobrevivência e meta-análise.

Os resultados numéricos de estudos não pareados podem ser comparados utilizando o teste t de amostras independentes, ou, se estiverem envolvidos mais de dois grupos, um teste como a análise de variância (ANOVA). Os resultados categóricos são geralmente analisados utilizando o teste de qui-quadrado para a associação. Para o desenho de um estudo emparelhado, a técnica de análise padrão é a do teste t de amostras emparelhadas ou as medidas repetidas ANOVA. Os estudos correlacionais são geralmente quantificados através do coeficiente de correlação de Pearson e podem ser estendidos para uma definição de regressão linear. Todos estes procedimentos são procedimentos paramétricos que fazem certas suposições distributivas sobre os dados; se estas suposições não forem cumpridas, as técnicas não paramétricas correspondentes, tais como o teste de rank-sum, o teste de rankings assinado, a avaliação do coeficiente de correlação de rank de Spearman ou os procedimentos de bootstrapping podem com frequência funcionar bastante bem. Todos os procedimentos podem ser facilmente implementados utilizando software estatístico padrão e todos produzirão uma avaliação da significância estatística, medida pelo valor p dado pelo software.

Embora o valor p facilite uma dedução da significância estatística ou não, este não nos dá uma medida de precisão nos nossos resultados. Este é outro lado dos testes inferenciais. Podemos encontrar na nossa amostra um efeito de uma determinada dimensão, mas não seria realista esperar que existisse um efeito de tal magnitude na população em geral. Embora nunca saberemos qual é realmente a dimensão do efeito populacional, é possível derivar para ele um intervalo de confiança (IC), também conhecido como intervalo de incerteza. Lsto é frequentemente interpretado vagamente como a gama de valores dentro da qual podemos afirmar com um certo grau de confiança (convencionalmente de 95%) que um valor populacional se encontra. Mais formalmente, se repetirmos o procedimento muitas vezes, então o intervalo de valores determinado em cada vez iria conter o verdadeiro parâmetro populacional em 95% das ocasiões.

Os IC não quantificam a força da prova contra a hipótese nula, como o valor p faz, mas em vez disso dão uma medida da precisão de uma estimativa (por exemplo, a diferença entre, ou a razão dos valores médios nos grupos de tratamento). Atualmente, os IC (e a estimativa do efeito em torno do qual se encaixam) são cada vez mais relatadas conjuntamente com os valores p nos testes estatísticos e parecem ser, para muitos, mais informativas e mais fáceis de compreender. Embora não façam parte de um teste de hipóteses, a maioria do software estatístico reportará automaticamente um IC como um subproduto do resultado do teste de hipóteses.

Existe uma correspondência exata entre o IC e o valor p correspondente: um IC 95% que exclui o valor chave 0 (para uma diferença entre grupos de estudo) ou 1 (para um rácio entre grupos de estudo) corresponde a um efeito significativo ao nível de significância de 5% (ou seja, um valor p inferior a 0,05). Por outro lado, um IC de 95% que inclua um valor chave corresponde a um valor p estatisticamente não significativo ao nível de 5% de significância (ou seja, é 0,05 ou superior). Atkinson et al5 investigaram o efeito de vários fatores no risco de infeção do local cirúrgico durante a cirurgia da coluna vertebral e numa apresentação típica de resultados tabelados (abaixo), relataram estatísticas de um modelo que incluía tanto valores p como IC. Note-se que o fator dos níveis da coluna vertebral, que é significativo de acordo com o valor de p (0,019), tem um rácio de probabilidade com um IC associado de 1,04 a 1,54, que exclui o valor chave (para um ratio) de 1; enquanto o fator da região espinal, que não é significativo de acordo com o valor de p (0,103), tem um rácio de probabilidade com um IC associado de 0,71 a 44,3, que inclui o valor chave. Esta tabela é também um bom exemplo de como um efeito de magnitude relativamente pequena pode ser significativo (cada nível adicional da coluna vertebral está associado a um aumento de 26% nas probabilidades de infeção); enquanto um efeito de grande magnitude (a cirurgia realizada na região torácica, em vez de não torácica, está associado a um aumento de cerca de cinco vezes nas probabilidades de infeção) pode não ser significativo.

Quadro 1: extrato da tabela de dados comunicados por Atkinson et al5

A seleção de um teste estatístico apropriado para um determinado desenho de estudo nem sempre é linear e direto e requer uma cuidadosa consideração dos parâmetros do estudo. Nenhum teste único é adequado para todos os tipos de estudos. Para estudos agrupados, tais como os desenhos não emparelhados e emparelhados discutidos anteriormente, podemos ter de considerar, por exemplo, o número de grupos, o tamanho dos grupos, a distribuição dos dados, a independência das unidades e a presença ou a ausência de fatores de confusão na seleção de um teste. Para estudos não agrupados, tais como estudos correlacionais, podemos querer considerar se os nossos dados se encontram sob a forma de dados em bruto ou de ordenações de classificação; e para estudos não agrupados que avaliam múltiplos fatores, podemos considerar se estamos potencialmente a sobreajustar os nossos dados (modelando o ruído em vez do sinal), tentando analisar uma excessiva quantidade de fatores para uma amostra de um determinado tamanho.

Medidas especiais são necessárias para desenhos complexos: por exemplo, quando os dados são agrupados (tais como pacientes dentro de enfermarias hospitalares, ou locais anatómicos em pacientes); quando são realizados múltiplos testes (tais como podem surgir em estudos com medidas de resultados múltiplos, onde a variável-chave de tratamento tem múltiplos níveis, ou onde análises separadas são conduzidas em subgrupos de indivíduos e/ou em múltiplos momentos no tempo); quando os resultados não são conhecidos exatamente (por exemplo, quando um resultado é o momento de um acontecimento adverso em pacientes que são monitorizados com pouca frequência); quando é efetuada uma série de observações sobre os mesmos pacientes; ou quando é necessário determinar uma estimativa sintetizada do efeito a partir de estudos múltiplos. Certas características dos dados, tais como a presença de extensos valores em falta ou inválidos ou discrepantes, podem também levar a uma exigência de processos estatísticos adicionais. Em todas estas situações é recomendado que se procure o conselho de um estatístico biomédico.

Author(s)

John Stephenson

PHD FRSS(GradStat) CMath(MIMA)

Senior Lecturer in Biomedical Statistics

University of Huddersfield, United Kingdom

Email J.Stephenson@hud.ac.uk

References

- Stephenson, J. (2022). Descriptive presentation of wound care data. World Council of Enterostomal Therapists Journal. 42, 3, p. 30-33

- Miller C, McGuiness W, Wilson S, Cooper K, Swanson T, Rooney D, Piller N, Woodward M (2017). Concordance and acceptability of electric stimulation therapy: a randomised controlled trial. Journal of Wound Care Vol. 26, No. 8. https://doi-org.libaccess.hud.ac.uk/10.12968/jowc.2017.26.8.508

- Lenselink E, Andriessen A (2011). A cohort study on the efficacy of a polyhexanide-containing biocellulose dressing in the treatment of biofilms in wounds. Journal of Wound Care 20 (534)

- Gunes EA, Eren MA, Koyuncu I, Taskin A, Sabuncu T (2018). Investigation of galectin-3 levels in diabetic foot ulcers. Journal of Wound Care (27); 12

- Atkinson R, Stephenson J, Jones A, Ousey K. An assessment of key risk factors for surgical site infection in patients undergoing surgery for spinal metastases J Wound Care 2016; 25(S9); S30-S34